- index

- >Projets

- >Projets antérieurs

- >ENGRAIS

Projet de Recherche ENGRAIS

Fusion de donnéEs pour la NaviGation (autonome) d’un Robot AgrIcole Symétrique

Équipes : Systèmes Dynamiques et Optimisation et Information, Signal, Image et Sciences du Vivant

Labellisation : aucune

Durée : 1 an (2019)

Financement : RFI Atlanstic 2020

Personnels impliqués du LARIS : Rémy Guyonneau, Étienne Belin, Philippe Lucidarme, Franck Mercier et Gabriel Freitas Oliveira

Partenaires du projet : Antoine Juan, Florian Gardes (ez-wheel)

Résumé

Le plan Ecophyto 2018 est en France l’une des actions proposées par le Grenelle de concertation sur les questions environnementales fin 2007. Ce plan a été réajusté en 2015 via le plan Ecophyto II qui vise une réduction de 50% des produits phytosanitaires d’ici 2025 (avec un pas de 25% pour 2020). Ainsi, la minimisation des produits phytosanitaires constitue un enjeu majeur pour l’agriculture française. Par exemple, une action forte est menée par l’état en ce moment visant à interdire le glyphosate en France d’ici à trois ans.

La communauté de la robotique est en effervescence pour proposer des alternatives crédibles pour le désherbage, et des robots commencent à apparaître (Naïo Technologie, Ecorobotix, Vitirover...). La problématique commune de ces robots est d’avoir une navigation adaptée aux cultures cibles. Cette navigation doit assurer plusieurs fonctions qui sont :

- Le positionnement adéquat du robot dans la rangée;

- La gestion de la couverture de la parcelle;

- L’assurance des fonctions de sécurité humaine, animale et matérielle.

Le point faible des robots proposés actuellement réside dans leur dépendance à une perception mono-modale, qui conduit à des limitations de fonctionnement. Ainsi un robot adapté au désherbage intra-rang dans le maraîchage (poireau, betterave, etc.), sur perception LiDAR1, ne peut fonctionner qu’à un certain stade de développement des cultures d’intérêts (désherbage précoce impossible), et en dessous d’un certain stade d’invasion des adventices. Ceci se justifie par le fait que dans le premier cas le LiDAR ne perçoit aucun végétal et ne peut pas se localiser, dans l’autre cas le LiDAR est noyé d’informations et ne peut pas extraire l’information utile à son positionnement. Cette démonstration est généralisable à tout autre robot mono-modale en multipliant les aléas, et conduit à la conclusion que la multiplicité des moyens de perception se complète bien et permettrait de rendre robuste la navigation des robots.

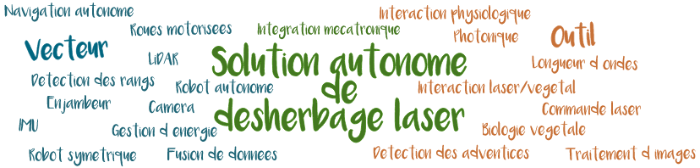

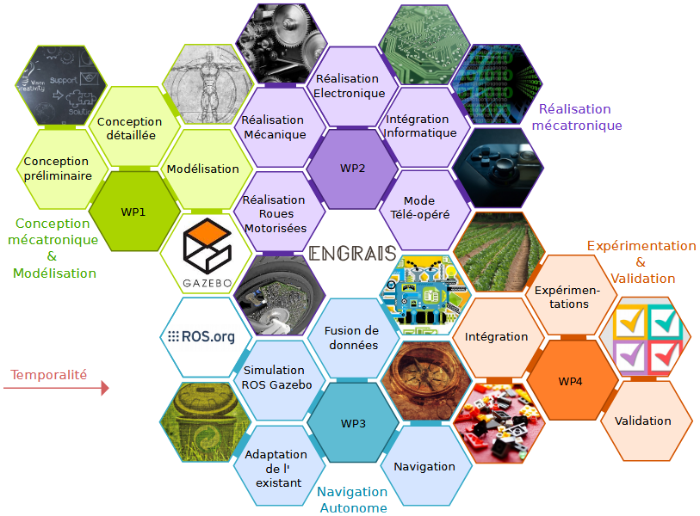

C’est l’enjeu du projet ENGRAIS qui vise à proposer un moyen de fusionner les modalités de perception pour en extraire une information utile pour la navigation. Cette fusion de données ouvre la porte à des robots multi-cultures, et cette nouvelle donne conduit à anticiper un démonstrateur apte à aborder différentes cultures.

Les réflexions menées et l’analyse de l’état de l’art ont conduit à proposer deux innovations importantes complémentaires à la fusion de données :

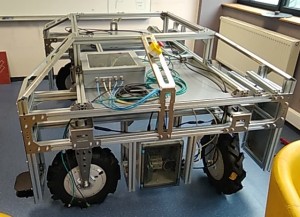

- La fabrication d’un robot symétrique, qui a la double particularité de limiter les manœuvres (notamment pendant le changement de rang) et donc le limiter le tassement des sols mais aussi d’augmenter les données de perception (à l’avant comme à l’arrière du robot) ce qui devrait permettre une navigation plus robuste;

- L’intégration d’une nouvelle technologie de roues embarquant la motorisation et l’énergie, permettant ainsi une meilleure stabilité par abaissement du centre de gravité et donc l’utilisation du robot en présence de fortes pentes, sans risquer le renversement.

La preuve de concept proposée pour le projet ENGRAIS est in fine de concevoir et réaliser ce robot symétrique basé sur une nouvelle technologie de mobilité, aussi bien matérielle (roues motorisées) que logicielle (fusion de données).

1 Light Detection And Ranging – un télémètre laser

Bibliographie

[AHM17] A. AHMAD, R. GUYONNEAU, F. MERCIER, E.BELIN, Image processing based on shape descriptors and SVM classifier for the crop plant/weed discrimination, The 20th World Congress of the international Federation of Automatic Control, Toulouse, 10-14 july, 2017.

[AHM18] A. AHMAD, R. GUYONNEAU, F. MERCIER, E. BELIN, On the use of shape and intensity features to discriminate crop plants and weeds from RGB images, International Conference on Image and Signal Processing (ICISP), Cherbourg, France, 2018.

[BEL00] T. Bell, Automatic tractor guidance using carrier-phase differential {GPS}, Computers and Electronics in Agriculture 25 (12) (2000) 53 – 66.

[BEN17] Benet, B., Lenain, R., & Rousseau, V. (2017). Development of a sensor fusion method for crop row tracking operations. Advances in Animal Biosciences, 8(2), 583-589.

[ECO18] The ecophyto 2018 plan, http://agriculture.gouv.fr/ecophyto-english, accessed: 2017-06-01.

[GER84] J. B. Gerrish, T. Surbrook, Mobile robots in agriculture, 1984 ASAE Publication. ASAE, p.30-41 12 p.

[HAG97] Hague, T., Marchant, J. A., & Tillett, N. D. (1997, April). Autonomous robot navigation for precision horticulture. In Robotics and Automation, 1997. Proceedings., 1997 IEEE International Conference on (Vol. 3, pp. 1880-1885). IEEE.

[HIR14] S. A. Hiremath, G. W. Van Der Heijden, F. K. Van Evert, A. Stein, C. J. Ter Braak, Laser range finder model for autonomous navigation of a robot in a maize field using a particle filter, Computers and Electronics in Agriculture 100 (2014) 41–50.

[ISA12] H. Isack, Y. Boykov, Energy-based geometric multi-model fitting, International journal of computer vision 97 (2) (2012) 123–147

[LEV11] Levinson, J., Askeland, J., Becker, J., Dolson, J., Held, D., Kammel, S., ... & Sokolsky, M. (2011, June). Towards fully autonomous driving: Systems and algorithms. In Intelligent Vehicles Symposium (IV), 2011 IEEE (pp. 163-168). IEEE.

[MAH06] Mahlisch, M., Hering, R., Ritter, W., & Dietmayer, K. (2006, September). Heterogeneous fusion of Video, LIDAR and ESP data for automotive ACC vehicle tracking. In Multisensor Fusion and Integration for Intelligent Systems, 2006 IEEE International Conference on (pp. 139-144). IEEE.

[MOR10] Moras, J., Cherfaoui, V., & Bonnifait, P. (2010, December). A lidar perception scheme for intelligent vehicle navigation. In Control Automation Robotics & Vision (ICARCV), 2010 11th International Conference on (pp. 1809-1814). IEEE.

[PRE12] M. Prez-Ruiz, D. Slaughter, C. Gliever, S. Upadhyaya, Automatic gps-based intra-row weed knife control system for transplanted row crops, Computers and Electronics in Agriculture 80 (2012) 41 – 49.

[RAS18] P. RASTI, A. AHMAD, E. BELIN, D. ROUSSEAU, Learning on deep network without the hot air by scattering transform. Application to weed detection in dense culture," 6th International Workshop on Image Analysis Methods for the Plant Sciences (IAMPS), Nottingham, 22-23 jan, 2018.

[REI87] J. Reid, S. Searcy, Vision-based guidance of an agriculture tractor, IEEE Control Systems Magazine 7 (2) (1987) 39–43.

[WOL08] Wöltjen, C., et al. "Plant growth depression by selective irradiation of the meristem with CO2 and diode lasers." Biosystems engineering 101.3 (2008): 316-324.

[ZHA99] ZHANG, Qin, REID, John F., et NOGUCHI, Noboru. Agricultural vehicle navigation using multiple guidance sensors. In : Proceedings of the International Conference on Field and Service Robotics. August, 1999. p. 293-298.